互聯(lián)網(wǎng)背景下“VR+聲樂演唱”的創(chuàng)新教育教學(xué)模式研究

作者:李延俊

發(fā)布時(shí)間:2024-04-09 10:47:06 來(lái)源:陜西教育·高教

[摘 要]為豐富學(xué)生的聲樂學(xué)習(xí)資源、節(jié)省教師人力資源,本研究提出將虛擬現(xiàn)實(shí)技術(shù)(Virtual Reality,VR)與聲樂演唱相結(jié)合,構(gòu)建一個(gè)新的虛擬教學(xué)系統(tǒng)。首先構(gòu)建一個(gè)虛擬學(xué)習(xí)系統(tǒng);接著提出一種基于Log-Gabor-改進(jìn)局部二值模式(Improved Local Binary Pattern,ILBP)的語(yǔ)譜圖特征算法,對(duì)不同尺寸與方向的語(yǔ)譜細(xì)節(jié)特征進(jìn)行放大,增強(qiáng)圖像紋理細(xì)節(jié)特征;最后引入多級(jí)殘差結(jié)構(gòu)-ICNN以彌補(bǔ)丟失的特征,提高對(duì)演唱者語(yǔ)音的識(shí)別率。結(jié)果顯示,在Saarbruecken數(shù)據(jù)集與CASIA數(shù)據(jù)集中,研究算法的收斂指標(biāo)值均最小,具有較高的收斂性;窗長(zhǎng)為600、譜窗尺寸大小為16×16時(shí),模型有最高語(yǔ)音識(shí)別效率。該算法對(duì)于演唱者的情感識(shí)別效果較好,準(zhǔn)確率均高于80%。以上結(jié)果均表明,本次研究的算法識(shí)別準(zhǔn)確率高,穩(wěn)定性好,能夠較好地運(yùn)用于聲樂演唱教育教學(xué)中。

[關(guān)鍵詞]VR 聲樂演唱 教學(xué)模式 創(chuàng)新教育

課題:本文系延安大學(xué)2022年疫情防控應(yīng)急科研項(xiàng)目《抗議歌曲原創(chuàng)〈疫情無(wú)情人有情〉》(課題編號(hào):ydfk052)。

中圖分類號(hào):TP393 文獻(xiàn)標(biāo)志碼:A

引 言

改革開放以來(lái),隨著電子信息技術(shù)的飛速發(fā)展,互聯(lián)網(wǎng)已全面融入人類社會(huì)文明、文化、政治與經(jīng)濟(jì)建設(shè)的全過程。當(dāng)前,網(wǎng)絡(luò)教學(xué)已得到了全社會(huì)的認(rèn)可、提倡和推廣。在音樂教育方面,隨著計(jì)算機(jī)技術(shù)和網(wǎng)絡(luò)的發(fā)展,傳統(tǒng)的線下聲樂演唱教學(xué)方式受到了前所未有的挑戰(zhàn),從根本上改變了音樂教育的教學(xué)模式。傳統(tǒng)聲樂演唱教學(xué)由于教師的時(shí)間有限、資源有限,學(xué)生的學(xué)習(xí)過程通常會(huì)受影響。鑒于此,本研究提出以互聯(lián)網(wǎng)為背景,將VR技術(shù)與聲樂演唱教育相互結(jié)合,創(chuàng)新一種新型線上教育模式。該模式既能夠增強(qiáng)學(xué)生間的交流與學(xué)習(xí),又可以加強(qiáng)教師與學(xué)生之間的溝通。

基于VR技術(shù)的聲樂演唱教育教學(xué)平臺(tái)模型構(gòu)建

1.基于VR技術(shù)的聲樂演唱教學(xué)系統(tǒng)及語(yǔ)譜圖特征提取

研究以虛擬現(xiàn)實(shí)技術(shù)為基礎(chǔ),構(gòu)建聲樂演唱教育教學(xué)新模型,首先對(duì)VR技術(shù)的特點(diǎn)與原理展開分析。VR實(shí)際上是一種能夠創(chuàng)造和體驗(yàn)虛擬世界的計(jì)算機(jī)模擬系統(tǒng),通過計(jì)算機(jī)技術(shù)產(chǎn)生一個(gè)能夠讓使用者完全沉浸其中的模擬環(huán)境。所謂“VR”,就是將真實(shí)的信息,通過計(jì)算機(jī)技術(shù)將其轉(zhuǎn)換為一種可以為人類所感知的現(xiàn)象。這種現(xiàn)象可以是現(xiàn)實(shí)中真真切切存在的物體,也可以是肉眼無(wú)法觀察到的物質(zhì)。有的現(xiàn)象人類無(wú)法直觀觀察到,但能通過計(jì)算機(jī)技術(shù)將其模擬為現(xiàn)實(shí),所以也被稱為虛擬現(xiàn)實(shí)。基于三維VR技術(shù)的沉浸式情景,能夠改變傳統(tǒng)的扁平式教學(xué)方式,賦予教學(xué)更生動(dòng)的教學(xué)場(chǎng)景,進(jìn)而重塑在線教育。虛擬現(xiàn)實(shí)聲樂演唱學(xué)習(xí)(VR-Learning)模式,能夠?qū)崿F(xiàn)教學(xué)內(nèi)容的在線可視化、教學(xué)環(huán)境的互動(dòng)虛擬化、教學(xué)過程的交互性。當(dāng)VR技術(shù)與聲樂演唱教育相結(jié)合,可將與音樂“握手”變?yōu)椤皳肀А保瑢W(xué)生能在虛擬環(huán)境中體驗(yàn)對(duì)虛擬人物與音樂的再創(chuàng)造。總之,“VR+聲樂演唱”是創(chuàng)新教育教學(xué)領(lǐng)域的重要使命,也是推動(dòng)我國(guó)音樂教育發(fā)展的巨大助力。

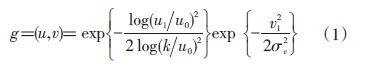

在基于VR技術(shù)的聲樂演唱?jiǎng)?chuàng)新教育教學(xué)系統(tǒng)設(shè)計(jì)中,語(yǔ)音情感識(shí)別占據(jù)著十分重要的位置。課題組對(duì)語(yǔ)音情感識(shí)別系統(tǒng)中的特征提取部分展開了較為深入的研究。語(yǔ)譜圖是對(duì)語(yǔ)音能量時(shí)頻分布的一種視覺表現(xiàn)形式,其紋理特征、能量分布信息與語(yǔ)音情感信號(hào)中的能量、音調(diào)以及基頻等情緒特征有著十分密切的關(guān)系。課題組擬利用語(yǔ)譜圖中的紋理特征等信息,從語(yǔ)譜圖中提取出與情感相關(guān)的特征,以減少時(shí)間域與頻率域信號(hào)之間的互斥性,進(jìn)而提高語(yǔ)音情感的識(shí)別效果。為了解決語(yǔ)譜圖中存在的情感特征提取不足的問題,提出了一種基于Log-Gabor-改進(jìn)局部二值模式的語(yǔ)譜圖特征算法。首先利用Log-Gabor從不同的尺度與方向?qū)叶群蟮恼Z(yǔ)譜圖細(xì)節(jié)地方特征進(jìn)行放大,然后利用ILBP從不同方向?qū)y理特征進(jìn)行提取與重構(gòu)。二維Log-Gabor具有較好的圖像紋理細(xì)節(jié)增強(qiáng)功能,同時(shí)還能夠抑制低頻信號(hào)的振幅,增強(qiáng)對(duì)高頻信號(hào)的放大作用。二維Log-Gabor表達(dá)見式(1)。

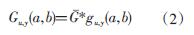

式(1)中,[u1,v1]表示[θ]的函數(shù)<Z:\趙爽\2024高教\2024.02.15\圖表\89-0-2.jpg>;[θ]表示濾波器的方向;[u0]表示濾波中心;[k,σv]表示[u1,v1]方向上的帶寬。假設(shè)語(yǔ)譜圖為[G],與[gu,y(u,v)]在時(shí)域上展開卷積神經(jīng)網(wǎng)絡(luò)結(jié)果的計(jì)算,得到的卷積表達(dá)式見式(2)。

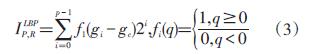

式(2)中,[v]表示變換尺度[(u?0,1,2,…,4)],對(duì)應(yīng)五個(gè)尺度;[v]表示變換方向[(v?0,1,2,…,7)],對(duì)應(yīng)八個(gè)變換方向;*表示卷積運(yùn)算庫(kù)。在[Gu,y(a,b)]系數(shù)矩陣中,不僅包含有原始信息的幅值信息,還包含有相位信息,其中相位信息對(duì)研究中國(guó)的語(yǔ)音情感識(shí)別沒有實(shí)際作用,因此舍去。接著引入ILBP,提取所構(gòu)建虛擬系統(tǒng)中聲樂演唱對(duì)應(yīng)的圖像畫面的局部紋理特征。將圖像像素點(diǎn)矩陣設(shè)置為[I],圖像的紋理特征圖譜[ILBPP,R]表達(dá)見式(3)。

式(3)中,[R]表示區(qū)域半徑(通常為3×3像素點(diǎn)網(wǎng)格);[gC]表示中心像素點(diǎn)的像素值;[P]表示區(qū)域內(nèi)所有像素點(diǎn)的總個(gè)數(shù)(通常等于8);[gi]表示每個(gè)像素點(diǎn)的像素值。ILBP是將傳統(tǒng)LBP作為基礎(chǔ)優(yōu)化而來(lái)的,ILBP能夠有效提高解決傳統(tǒng)算法在提取圖像紋理特征時(shí)的局部細(xì)節(jié)表現(xiàn)能力較弱的問題。改進(jìn)后的LBP表達(dá)見式(4)。

式(4)中,[E]表示周圍像素點(diǎn)與中心像素點(diǎn)之間的平均絕對(duì)百分比誤差,通過對(duì)每個(gè)像素點(diǎn)的絕對(duì)百分比誤差與平均誤差大小來(lái)設(shè)定閾值,能夠較為全面地體現(xiàn)周圍像素點(diǎn)與中心點(diǎn)的絕對(duì)誤差關(guān)系,進(jìn)而通過計(jì)算得到的LBP值會(huì)更為準(zhǔn)確。

2.基于改進(jìn)CNN的聲樂演唱語(yǔ)音情感識(shí)別模型

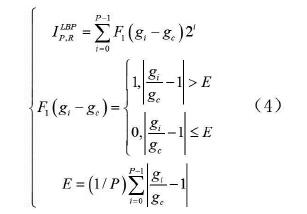

研究對(duì)聲樂演唱特征提取過程中容易丟失的現(xiàn)象進(jìn)行了改進(jìn),提出了一種基于多級(jí)殘差改進(jìn)的卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Networks,CNN),以彌補(bǔ)丟失的特征,提高識(shí)別率。

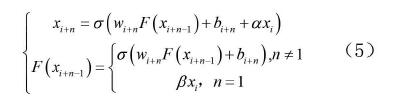

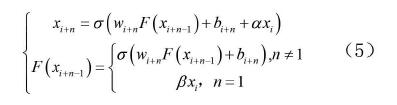

圖2中,改進(jìn)卷積神經(jīng)網(wǎng)絡(luò)包含多個(gè)卷積池化層與多級(jí)殘差結(jié)構(gòu),其中多級(jí)殘差結(jié)構(gòu)能夠跨越多個(gè)池化層傳遞原始信息特征,可彌補(bǔ)丟失特征。正方形框中表示研究所涉及的多級(jí)殘差結(jié)構(gòu),n和m分別代表殘差結(jié)構(gòu)傳播跨越的卷積層個(gè)數(shù)。本研究改進(jìn)的多級(jí)殘差卷積神經(jīng)網(wǎng)絡(luò)在解決傳統(tǒng)CNN結(jié)構(gòu)弊端的基礎(chǔ)上,能夠進(jìn)一步降低計(jì)算量,進(jìn)而提高模型識(shí)別效率。研究提出的多級(jí)殘差結(jié)構(gòu)以殘差結(jié)構(gòu)為基礎(chǔ),對(duì)卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行了改進(jìn)。多級(jí)殘差結(jié)構(gòu)通過將前n個(gè)卷積層的原始信息與所在的卷積層相互聯(lián)系,最大程度地保留了原始信息,并通過加入控制系數(shù)對(duì)所輸入原始特征的維度進(jìn)行調(diào)控,最終有效提高了模型的識(shí)別效率與系統(tǒng)的收斂速度。若將引出殘差結(jié)構(gòu)時(shí)的輸入設(shè)為[xi],引入殘差結(jié)構(gòu)后的輸出為[xi+n],那么相應(yīng)得到的多級(jí)殘差結(jié)構(gòu)的輸出見式(5)。

式(5)中,[α,β]表示控制系數(shù),被用來(lái)限制輸入特征的維度。若損失函數(shù)為C,對(duì)應(yīng)得到的反向傳播的權(quán)值表達(dá)式則更新為式(6)。

式(6)中,

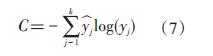

表示多級(jí)殘差結(jié)構(gòu)對(duì)應(yīng)補(bǔ)充的丟失特征項(xiàng);[T(w,b)]表示權(quán)值與偏置的常數(shù)項(xiàng)。在對(duì)卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行逐層求解時(shí),權(quán)重[w]將逐步減小,直至接近0,從而導(dǎo)致反向傳遞的梯度更新接近于0,最終造成特征損失的現(xiàn)象。加入多層次殘差結(jié)構(gòu)后,能夠引入最初[n]個(gè)卷積層的原始特征信息,使特征得到最大限度的互補(bǔ),同時(shí)設(shè)定控制參數(shù)[α]和[β],則能夠減小特征維度,最終加快訓(xùn)練速度,提高訓(xùn)練效果。聲樂演唱過程中對(duì)語(yǔ)音情感識(shí)別的訓(xùn)練可以被認(rèn)為是使用一套被估計(jì)的參數(shù)來(lái)刻畫實(shí)際數(shù)據(jù)與預(yù)測(cè)數(shù)據(jù)的差異,并通過不斷調(diào)節(jié)這些差異,使得兩者的差異實(shí)現(xiàn)最小。在此基礎(chǔ)上,提出了一種全新的、能夠用來(lái)指導(dǎo)整個(gè)系統(tǒng)的函數(shù)——損失函數(shù)。由于語(yǔ)音情感識(shí)別過程中存在著多類別的特征,再將交叉熵引入到語(yǔ)音情感識(shí)別中,其對(duì)應(yīng)表達(dá)見式(7)。

式(7)中,[yj]表示第[j]個(gè)樣本的真實(shí)標(biāo)簽;[yj]表示第[j]個(gè)樣本在所構(gòu)建模型中的預(yù)測(cè)輸出。交叉熵所描述的問題是輸出結(jié)果與真實(shí)數(shù)值之間的差異程度,若輸出結(jié)果中被正確分類的樣本較多,則對(duì)應(yīng)得到的交叉熵?cái)?shù)值較小,即表示輸出結(jié)果的混亂程度越小,最終得到的模型性能較好。

另外,還需要選取適當(dāng)?shù)膬?yōu)化算法,使得神經(jīng)網(wǎng)絡(luò)的損失函數(shù)值最小化。最常見的方法便是利用梯度下降的方法來(lái)最小化損失函數(shù),對(duì)此,課題組提出使用RMSProp算法(具有全參數(shù)自適應(yīng)的特點(diǎn)),具體表達(dá)見式(8)。

式(8)中,[r]表示梯度平方值的滑動(dòng)率;[w]表示衰減率;[a]表示學(xué)習(xí)率;[ε]表示防止分母為零的常數(shù)項(xiàng);[η]表示超參數(shù)(是一個(gè)常量)。除此之外,為了避免過擬合現(xiàn)象的出現(xiàn),采用了正則化方法。該方法是一種能夠?qū)ι窠?jīng)網(wǎng)絡(luò)結(jié)果中的神經(jīng)元進(jìn)行隨機(jī)忽略的一種有效訓(xùn)練策略。

“VR+聲樂演唱”創(chuàng)新教育教學(xué)模式的實(shí)現(xiàn)與測(cè)試

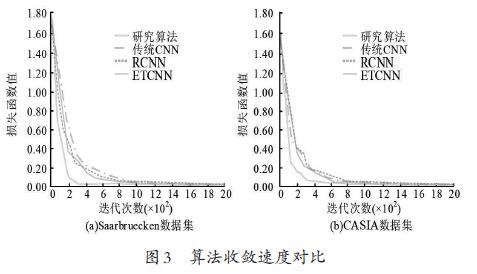

本研究選取某大學(xué)聲樂教育專業(yè)的學(xué)生作為研究對(duì)象,通過VR技術(shù)建立聲樂演唱遠(yuǎn)程在線教育平臺(tái),對(duì)所構(gòu)建平臺(tái)的實(shí)際性能與應(yīng)用效果進(jìn)行分析。首先分析所構(gòu)建模型的收斂速度,選擇德國(guó)薩爾布呂肯語(yǔ)音數(shù)據(jù)集(Saarbruecken)和中國(guó)聲樂語(yǔ)音情感數(shù)據(jù)庫(kù)(CASIA)兩個(gè)不存在交叉的數(shù)據(jù)集作為測(cè)試數(shù)據(jù)集。對(duì)比不同算法的收斂速度,見圖3所示。

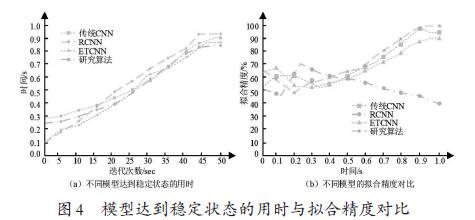

從圖3可知,選取傳統(tǒng)CNN、RCNN與ETCNN作為對(duì)比算法,比較三種算法與本次研究所提出的改進(jìn)CNN算法之間的收斂性。圖3(a)是在Saarbruecken數(shù)據(jù)集中的測(cè)試結(jié)果,顯示研究算法最快能在迭代進(jìn)行到第200次時(shí)獲得較小的指標(biāo)值,而其余三種散發(fā)均在迭代進(jìn)行到第800次后獲得較小指標(biāo)值。圖3(b)是在CASIA數(shù)據(jù)集中的測(cè)試結(jié)果,當(dāng)?shù)螖?shù)在第200次時(shí),研究算法有最小指標(biāo)值;其余算法則在第800次左右才能有最小值。這表示研究算法具有較高的收斂性,即研究所提出算法計(jì)算過程的效率更高,從不同數(shù)據(jù)集的結(jié)果可以得知,該算法具有較高的普適性。接著對(duì)不同算法模型達(dá)到穩(wěn)定狀態(tài)的用時(shí)與擬合精度進(jìn)行對(duì)比,見圖4。

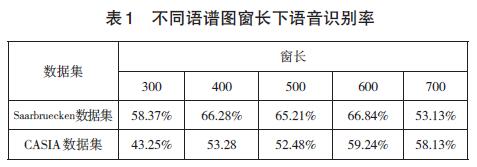

從圖4(a)可以看出,隨著迭代次數(shù)的增加,4種算法的穩(wěn)定狀態(tài)運(yùn)行時(shí)間均在上升,并在運(yùn)行時(shí)間為45次時(shí)趨向于穩(wěn)定。當(dāng)?shù)螖?shù)達(dá)到50次時(shí),所有算法運(yùn)行均達(dá)到穩(wěn)定狀態(tài),此時(shí)傳統(tǒng)CNN、RCNN與ETCNN三種算法達(dá)到穩(wěn)定狀態(tài)的用時(shí)分別為0.912s、0.934s、0.876s,而研究算法的穩(wěn)定用時(shí)為0.849s。研究算法的用時(shí)最少,這可能是因?yàn)檠芯克惴ㄈ谌肓硕嗉?jí)殘差結(jié)構(gòu),一定程度上簡(jiǎn)化了系統(tǒng)操作步驟,提升了運(yùn)行效率。從圖4(b)可以看出,隨著運(yùn)行時(shí)間的增加,系統(tǒng)中的擬合精度也開始逐漸增加。以時(shí)間為0.9s為例,此時(shí)研究算法的擬合精度為99.89%,此刻傳統(tǒng)CNN的擬合精度與研究算法不相上下,但當(dāng)運(yùn)行時(shí)間增加至1.0s時(shí),系統(tǒng)的擬合精度明顯下降。而RCNNN與ETCNN算法的擬合精度明顯小于研究算法。以上結(jié)果表明,研究算法的擬合精度最優(yōu)秀,能夠顯著減少系統(tǒng)達(dá)到穩(wěn)定的耗時(shí)。對(duì)不同Log-Gabor的譜窗長(zhǎng)度對(duì)系統(tǒng)語(yǔ)音的識(shí)別結(jié)果進(jìn)行總結(jié),結(jié)果見表1。

表1中可以發(fā)現(xiàn),窗長(zhǎng)對(duì)識(shí)別率有較大影響的波峰分別在窗長(zhǎng)接近于400與600時(shí)。主要原因在于當(dāng)窗長(zhǎng)接近于400時(shí),語(yǔ)譜圖更接近于網(wǎng)絡(luò)帶寬語(yǔ)譜圖,聲樂演唱虛擬系統(tǒng)中的圖像顯示時(shí)域紋理更清晰;而當(dāng)窗長(zhǎng)接近于600時(shí),則更接近于窄帶語(yǔ)譜圖,頻域的紋理特征更清晰。對(duì)比可知,當(dāng)窗長(zhǎng)為600時(shí),在Saarbruecken數(shù)據(jù)集與CASIA數(shù)據(jù)集中,均有最高識(shí)別率,分別為66.84%、59.24%,因此語(yǔ)譜圖窗長(zhǎng)設(shè)定為600。不同譜窗大小對(duì)系統(tǒng)語(yǔ)音的識(shí)別效果見表2。

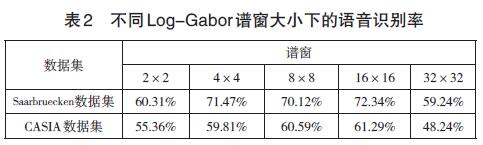

從表2可以看出,隨著譜窗尺寸的增加,識(shí)別率呈現(xiàn)先升后降的變化,譜窗大小為16×16時(shí),在Saarbruecken數(shù)據(jù)集與CASIA兩數(shù)據(jù)集上有最大識(shí)別率,分別為72.34%與61.29%。這是由于譜窗尺寸較小時(shí),研究算法著重強(qiáng)調(diào)圖像細(xì)節(jié),忽略了對(duì)整體虛擬系統(tǒng)的抗噪聲能力,導(dǎo)致識(shí)別率變小;而尺寸較大時(shí),研究算法提取的圖像與語(yǔ)音細(xì)節(jié)變得較小,識(shí)別率也較低。因此將譜窗尺寸大小設(shè)置為16×16,可取最優(yōu)識(shí)別率對(duì)應(yīng)尺寸。

另外,統(tǒng)計(jì)不同模型在兩種數(shù)據(jù)集上對(duì)每種聲樂演唱語(yǔ)音情感的識(shí)別率。可以發(fā)現(xiàn),研究算法對(duì)于演唱者的生氣、驚喜、厭惡以及悲傷的識(shí)別效果較好,準(zhǔn)確率均高于80%;與RCNN和ETCNN對(duì)比可知,研究算法模型對(duì)于生氣、厭惡、難過以及驚喜的識(shí)別率均高于其他兩種算法,其中對(duì)害怕情感的識(shí)別率較低,這是由于中文語(yǔ)言與外國(guó)語(yǔ)言的情緒表達(dá)方式不同。以上結(jié)果均表明,研究算法對(duì)生氣、難過、厭惡以及驚喜的識(shí)別率均顯著優(yōu)于文獻(xiàn)算法,對(duì)害怕與高興的識(shí)別率較低,對(duì)中性情感的波動(dòng)較大,整體識(shí)別效果較好。

結(jié) 論

為了豐富學(xué)生的學(xué)習(xí)資源,增強(qiáng)其學(xué)習(xí)互動(dòng)性,課題組將VR技術(shù)與聲樂演唱相互結(jié)合,創(chuàng)新了教學(xué)模式。研究過程中利用Log-Gabor和改進(jìn)LBP對(duì)語(yǔ)譜圖特征進(jìn)行提取,并引入多級(jí)殘差結(jié)構(gòu)改進(jìn)CNN彌補(bǔ)丟失的語(yǔ)音特征,提高識(shí)別率。結(jié)果顯示,研究算法的損失函數(shù)最小,收斂精度較高,識(shí)別準(zhǔn)確率較優(yōu),穩(wěn)定性能較優(yōu)。隨著聲樂演唱形式與科學(xué)技術(shù)的不斷發(fā)展,為了更好地構(gòu)建教學(xué)系統(tǒng),相關(guān)研究者還必須進(jìn)行更多的實(shí)驗(yàn),以豐富教學(xué)資源。

參考文獻(xiàn):

[1]田一淇.基于“互聯(lián)網(wǎng)+”的學(xué)前教育聲樂教學(xué)模式創(chuàng)新研究[J].電腦知識(shí)與技術(shù)(學(xué)術(shù)版)[J].2022,18(3):128-129+132.

[2]張帥,曲校辰,崔文超,等.VR技術(shù)在創(chuàng)新教育背景下的探索與實(shí)踐[J].山西青年,2020(5):94.

[3]Kowalski S,P Samól,J Szczepański,et al.Teaching architectural history through virtual reality[J].World Transactions on Engineering and Technology Education,2020,18(2):297-302.

[4]馮玲玲.“互聯(lián)網(wǎng)+”聲樂教學(xué)模式分析[J].普洱學(xué)院學(xué)報(bào),2021,37(1):131-132.

[5]Byrns A,Abdessalem H B,Cuesta M,et alEEG Analysis of the Contribution of Music Therapy and Virtual Reality to the Improvement of Cognition in Alzheimer's Disease[J].Journal of Biomedical Science and Engineering,2020,13(8):187-201.

[6]盤東霞,付夢(mèng)晗,等.我國(guó)虛擬現(xiàn)實(shí)技術(shù)教育應(yīng)用研究綜述——基于知識(shí)圖譜的可視化分析[J].廣州廣播電視大學(xué)學(xué)報(bào),2022,22(1):18-22+107-108.

[7]劉班.利用虛擬現(xiàn)實(shí)推進(jìn)高校創(chuàng)新創(chuàng)業(yè)人才培養(yǎng)[J].現(xiàn)代教育論壇,2020,3(8):85-87.

(李延俊:延安大學(xué)魯迅藝術(shù)學(xué)院)

熱點(diǎn)新聞

熱點(diǎn)新聞

深度報(bào)道

深度報(bào)道

新聞視頻

新聞視頻

投稿

投稿 APP下載

APP下載